项目名称:17k小说网更新记录分析平台

专业方向:大数据开发

指导老师:王科

项目成员:熊建东、雷友奇、肖健、王瑞、李虎生、石宏宇、李齐齐

项目介绍:

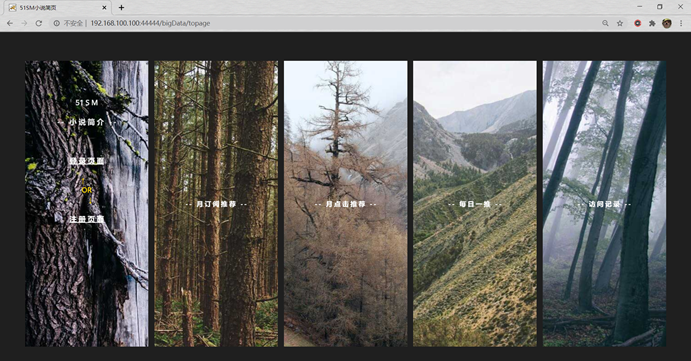

该项目主要是通过对17k小说网的更新情况的爬取和生成模拟更新的数据并利用SparkCore进行数据分析,最后通过web进行结果的展示。

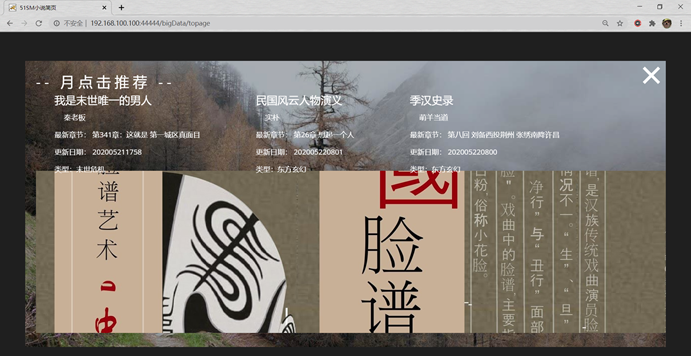

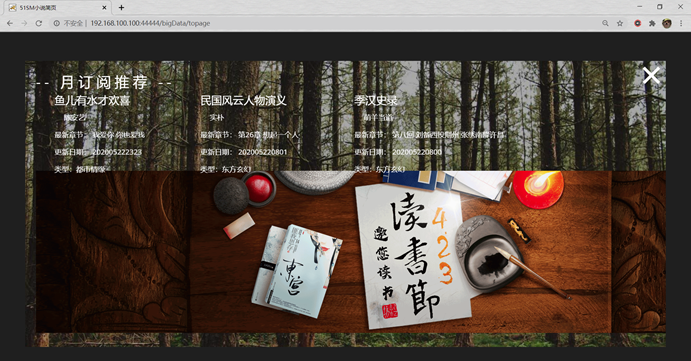

首先通过爬虫获取5月底近7天小说的更新记录以及小说的订阅、点击情况;通过spark进行数据清洗并对爬虫数据进行分析。数据生成我们采用实时模拟爬虫数据的生成,并考虑数据生成的规范,生成不同时段、不同字数段的更新记录,并将生成的数据直接存入hdfs,对生成的数据进行现场分析,分析生成数据的结果和爬虫数据的结果均先放入集群本地磁盘,接着通过flume监听存放分析结果的目录并将结果放入kafka指定的topic供sparkstreaming消费;sparkstreaming将结果数据存入MySQL数据库。

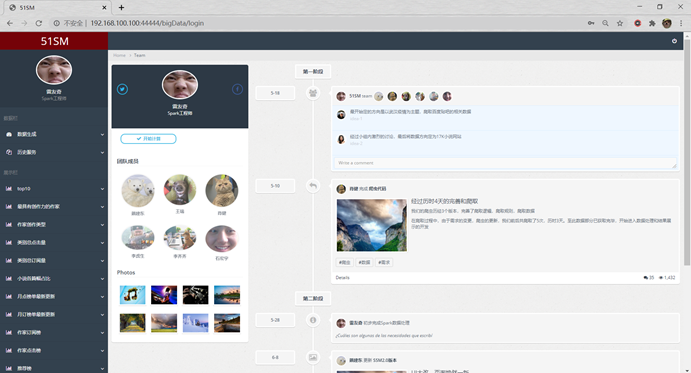

最后从MySQL数据库提取分析结果到web数据可视端进行展示,web数据可视化用到了spring、springMVC、mybatis、echarts,整个web端到大数据端是通过自动化脚本实现自动化命令提交。

项目链接:http://192.168.100.100:44444/bigData/

展示图片:

演示视频: